Como a IA irá remodelar os Testes de Software e a Engenharia de Qualidade em 2026

2025 viu a IA generativa avançar para as equipas de software a uma velocidade extraordinária, mas a maioria das organizações está agora a perceber que transformar a experimentação inicial em valor tangível é muito mais difícil do que o hype inicialmente sugeria.

O World Quality Report 2025 da Capgemini descobriu que quase 90 por cento das organizações estão agora a pilotar ou a implementar IA generativa nos seus processos de engenharia de qualidade, mas apenas 15 por cento alcançaram uma implementação em toda a empresa. O resto permanece nas fases iniciais, a tatear através de provas de conceito, implementações limitadas ou experiências que nunca chegam a escalar.

Esta lacuna entre entusiasmo e implementação aponta para uma verdade simples: velocidade e novidade por si só não são suficientes para entregar software de qualidade. Com a IA a mudar a forma como as equipas pensam sobre testes, as organizações precisam de construir intencionalmente as fundações que tornarão a engenharia de qualidade suportada por IA escalável em 2026.

Velocidade não é igual a qualidade

Muitas equipas são atraídas pela IA devido à sua capacidade de gerar testes e código com velocidade notável. Por exemplo, vi pessoas alimentarem um documento Swagger num modelo de IA para gerar um conjunto de testes de API em minutos. No entanto, ao rever os testes, pudemos ver quantos desses resultados eram falhos ou sobre-engenheirados.

Quando as equipas deixam este nível de revisão de qualidade para o fim, muitas vezes descobrem demasiado tarde que a velocidade ganha inicialmente é compensada pelo tempo gasto a retrabalhar o que a IA produziu. E sem surpresa, este padrão está a tornar-se comum porque a IA pode acelerar a geração, mas não pode garantir que o que produz seja significativo.

Pode alucinar condições, ignorar contexto de domínio ou mesmo interpretar mal casos extremos. E sem supervisão forte em cada fase, as equipas acabam por implementar código que passou grandes volumes de testes mas não necessariamente os testes certos.

Em 2026, isto irá levar as organizações a priorizar estruturas de revisão de qualidade construídas especificamente para artefactos gerados por IA, mudando os testes de práticas orientadas por volume para práticas orientadas por valor. É aqui que a ideia de qualidade contínua se tornará cada vez mais essencial.

Qualidade contínua

Engenharia de qualidade como termo pode por vezes dar a impressão de que qualidade é algo entregue por ferramentas ou por uma função de engenharia distinta considerada no fim. A qualidade contínua assume uma visão mais ampla e realista; é a ideia de que a qualidade começa muito antes de uma linha de código ser escrita e continua muito depois de um lançamento entrar em funcionamento.

Em vez de tratar os testes como uma porta final, implementar testes de qualidade em cada fase integra conversas focadas em qualidade no design, planeamento e discussões arquiteturais. Este processo contínuo por sua vez define expectativas em torno de dados, risco e resultados cedo, para que quando as ferramentas de IA produzem testes ou análises, as equipas já estejam alinhadas sobre o que parece bom.

Esta abordagem reflete o familiar ciclo infinito usado em DevOps. Testes, validação e melhoria nunca estão isolados. Fluem através do ciclo de vida de entrega, fortalecendo consistentemente a resiliência dos sistemas; quando as organizações adotam esta mentalidade, a IA torna-se um contribuidor para a qualidade em vez de uma barreira.

À medida que a IA se torna mais profundamente incorporada nos pipelines, a qualidade contínua será o modelo que determinará se a IA se torna um facilitador de melhor software em 2026 ou uma fonte de falhas imprevisíveis.

Alinhar a adoção de IA com objetivos de qualidade reais

Uma vez que a qualidade se torna uma atividade contínua, o próximo desafio é compreender como a IA amplifica a complexidade já presente nos sistemas empresariais. Introduzir testes gerados por IA ou código escrito por IA em grandes bases de código interdependentes aumenta a importância de saber como até pequenas mudanças podem afetar o comportamento noutros lugares. As equipas de qualidade devem ser capazes de rastrear como os resultados impulsionados por IA interagem com sistemas que evoluíram ao longo de muitos anos.

Os líderes seniores estão a colocar pressão sobre as equipas para adotarem IA rapidamente, muitas vezes sem alinhamento claro sobre os problemas que a IA deve resolver. Isto reflete os primeiros dias da automação de testes, quando as equipas foram instruídas a automatizar sem compreender o que esperavam alcançar. O resultado é muitas vezes investimento desperdiçado e conjuntos de testes inchados que são caros de manter.

A questão mais importante que as organizações serão obrigadas a fazer em 2026 é porquê querem usar IA, particularmente decidir os resultados específicos que querem melhorar, os tipos de risco que querem reduzir, e a parte do processo de entrega que mais tem a ganhar com o suporte de IA. Quando as equipas começam com estas considerações em vez de as tratar como reflexões posteriores, a adoção de IA tornar-se-á intencional em vez de reativa.

O papel em evolução do testador num pipeline ativado por IA

Esta mudança para uma adoção mais deliberada de IA muda naturalmente aquilo em que os profissionais de qualidade passam o seu tempo. À medida que a IA se incorpora nos pipelines de desenvolvimento, os testadores já não estão simplesmente a executar ou a manter casos de teste. Atuam cada vez mais como avaliadores que determinam se os artefactos gerados por IA realmente fortalecem a qualidade ou introduzem novo risco.

À medida que os sistemas de IA começam a gerar testes e a analisar grandes volumes de resultados, os testadores movem-se de executores práticos para decisores estratégicos que moldam como a IA é usada. O seu foco muda de escrever casos de teste individuais para guiar o output gerado por IA, determinando se reflete risco de negócio real e garantindo que as lacunas não são ignoradas.

Esta expansão de responsabilidade inclui agora a validação dos próprios modelos de IA e aprendizagem automática. Os testadores devem examinar estes sistemas quanto a preconceitos, desafiar os seus padrões de tomada de decisão e confirmar que o comportamento permanece previsível sob condições em mudança. É menos sobre verificar regras fixas e mais sobre compreender como os sistemas de aprendizagem se comportam nos seus limites.

A qualidade dos dados torna-se uma pedra angular deste trabalho. Uma vez que dados pobres levam diretamente a desempenho de IA pobre, os testadores avaliam os pipelines que alimentam modelos de IA, verificando precisão, completude e consistência. Compreender a conexão entre dados falhos e decisões falhas permite que as equipas previnam problemas muito antes de chegarem à produção.

Embora a IA certamente não vá substituir os testadores em 2026, continuará a remodelar o seu papel num que é mais analítico, interpretativo e orientado por contexto. A perícia necessária para guiar a IA responsavelmente é precisamente o que impede as organizações de caírem em risco à medida que a adoção acelera – e o que irá em última análise determinar se a IA fortalece ou mina a procura de qualidade contínua.

Preparar para 2026

À medida que estas responsabilidades se expandem, as organizações devem abordar o próximo ano com clareza sobre o que permitirá à IA entregar valor a longo prazo. As empresas que terão sucesso serão aquelas que tratam a qualidade como uma disciplina contínua que combina pessoas, processo e tecnologia, em vez de algo que pode ser automatizado.

A IA continuará a remodelar o panorama de testes, mas o seu sucesso depende de quão bem as organizações equilibram automação com julgamento humano. Aquelas que incorporam qualidade contínua no coração dos seus ciclos de entrega estarão melhor posicionadas para passar da experimentação para valor genuíno e sustentável em 2026.

Você também pode gostar

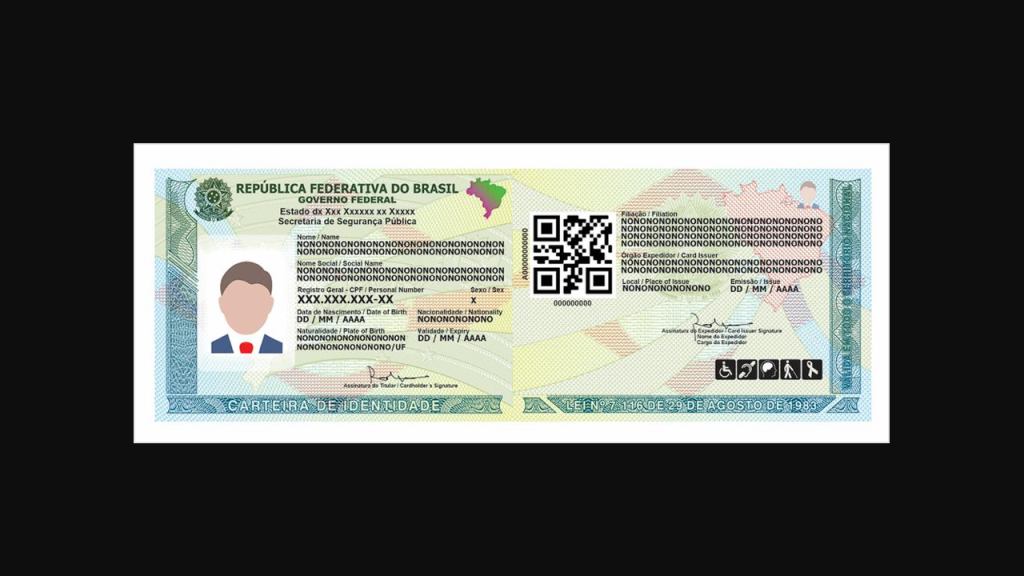

O famoso RG está prestes a ter fim: nova carteira de identidade já pode ser emitida de graça

Raio atinge apoiadores de Nikolas que aguardavam ato em Brasília