Обнаружение аномалий на основе трансформеров с использованием встраивания последовательностей логов

Таблица ссылок

Аннотация

1 Введение

2 Предпосылки и связанные работы

2.1 Различные формулировки задачи обнаружения аномалий на основе логов

2.2 Контролируемое и неконтролируемое обучение

2.3 Информация в данных логов

2.4 Группировка с фиксированным окном

2.5 Связанные работы

3 Настраиваемый подход к обнаружению аномалий на основе трансформеров

3.1 Формулировка проблемы

3.2 Парсинг логов и встраивание логов

3.3 Позиционное и временное кодирование

3.4 Структура модели

3.5 Контролируемая бинарная классификация

4 Экспериментальная установка

4.1 Наборы данных

4.2 Метрики оценки

4.3 Генерация последовательностей логов различной длины

4.4 Детали реализации и экспериментальная среда

5 Экспериментальные результаты

5.1 RQ1: Как работает наша предложенная модель обнаружения аномалий по сравнению с базовыми моделями?

5.2 RQ2: Насколько последовательная и временная информация в последовательностях логов влияет на обнаружение аномалий?

5.3 RQ3: Насколько различные типы информации индивидуально способствуют обнаружению аномалий?

6 Обсуждение

7 Угрозы достоверности

8 Выводы и ссылки

\

3 Настраиваемый подход к обнаружению аномалий на основе трансформеров

В этом исследовании мы представляем новый метод обнаружения аномалий на основе трансформеров. Модель принимает последовательности логов в качестве входных данных для обнаружения аномалий. Модель использует предварительно обученную модель BERT для встраивания шаблонов логов, что позволяет представлять семантическую информацию в сообщениях логов. Эти встраивания, в сочетании с позиционным или временным кодированием, впоследствии подаются в модель трансформера. Объединенная информация используется в последующей генерации представлений на уровне последовательности логов, облегчая процесс обнаружения аномалий. Мы разработали нашу модель гибкой: входные функции настраиваются так, чтобы мы могли использовать или проводить эксперименты с различными комбинациями функций данных логов. Кроме того, модель разработана и обучена для обработки входных последовательностей логов различной длины. В этом разделе мы представляем формулировку нашей проблемы и детальный дизайн нашего метода.

\ 3.1 Формулировка проблемы

Мы следуем предыдущим работам [1], чтобы сформулировать задачу как задачу бинарной классификации, в которой мы обучаем нашу предложенную модель классифицировать последовательности логов на аномальные и нормальные контролируемым способом. Для образцов, используемых в обучении и оценке модели, мы используем гибкий подход к группировке для генерации последовательностей логов различной длины. Подробности представлены в разделе 4

\ 3.2 Парсинг логов и встраивание логов

В нашей работе мы преобразуем события логов в числовые векторы путем кодирования шаблонов логов с помощью предварительно обученной языковой модели. Для получения шаблонов логов мы используем парсер Drain [24], который широко используется и имеет хорошую производительность парсинга на большинстве общедоступных наборов данных [4]. Мы используем предварительно обученную модель sentence-bert [25] (т.е. all-MiniLML6-v2 [26]) для встраивания шаблонов логов, сгенерированных в процессе парсинга логов. Предварительно обученная модель обучается с целью контрастного обучения и достигает современных результатов в различных задачах NLP. Мы используем эту предварительно обученную модель для создания представления, которое фиксирует семантическую информацию сообщений логов и иллюстрирует сходство между шаблонами логов для последующей модели обнаружения аномалий. Выходная размерность модели составляет 384.

\ 3.3 Позиционное и временное кодирование

Оригинальная модель трансформера [27] использует позиционное кодирование, чтобы позволить модели использовать порядок входной последовательности. Поскольку модель не содержит рекуррентности и свертки, модели будут агностичны к последовательности логов без позиционного кодирования. Хотя некоторые исследования предполагают, что модели трансформеров без явного позиционного кодирования остаются конкурентоспособными со стандартными моделями при работе с последовательными данными [28, 29], важно отметить, что любая перестановка входной последовательности будет производить одинаковое внутреннее состояние модели. Поскольку последовательная информация или временная информация могут быть важными индикаторами аномалий в последовательностях логов, предыдущие работы, основанные на моделях трансформеров, используют стандартное позиционное кодирование для внедрения порядка событий логов или шаблонов в последовательность [11, 12, 21], стремясь обнаружить аномалии, связанные с неправильным порядком выполнения. Однако мы заметили, что в часто используемой реализации репликации метода на основе трансформера [5] позиционное кодирование было фактически опущено. Насколько нам известно, ни одна из существующих работ не кодировала временную информацию на основе временных меток логов для своего метода обнаружения аномалий. Эффективность использования последовательной или временной информации в задаче обнаружения аномалий неясна.

\ В нашем предложенном методе мы пытаемся включить последовательное и временное кодирование в модель трансформера и исследовать важность последовательной и временной информации для обнаружения аномалий. В частности, наш предложенный метод имеет различные варианты, использующие следующие методы последовательного или временного кодирования. Затем кодирование добавляется к представлению лога, которое служит входом в структуру трансформера.

\

3.3.1 Кодирование относительного времени (RTEE)

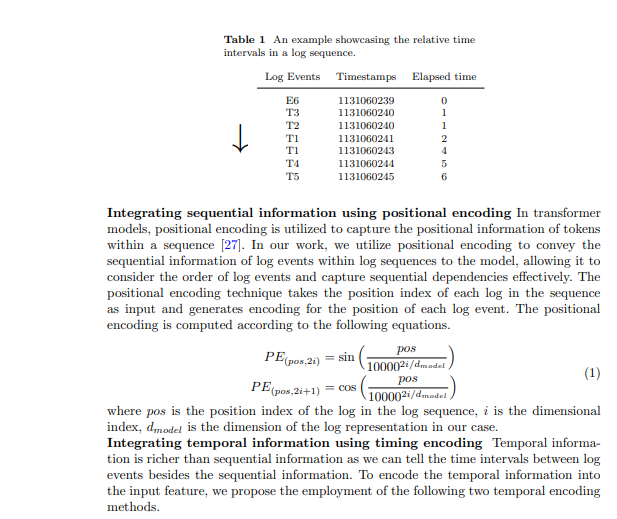

Мы предлагаем этот метод временного кодирования, RTEE, который просто заменяет индекс позиции в позиционном кодировании на время каждого события лога. Сначала мы вычисляем время, прошедшее согласно временным меткам событий логов в последовательности логов. Вместо использования индекса последовательности событий лога в качестве позиции для синусоидальных и косинусоидальных уравнений, мы используем относительное время, прошедшее от первого события лога в последовательности логов, чтобы заменить индекс позиции. Таблица 1 показывает пример временных интервалов в последовательности логов. В примере у нас есть последовательность логов, содержащая 7 событий с временным промежутком в 7 секунд. Время, прошедшее от первого события до каждого события в последовательности, используется для расчета временного кодирования для соответствующих событий. Аналогично позиционному кодированию, кодирование рассчитывается с помощью вышеупомянутых уравнений 1, и кодирование не будет обновляться в процессе обучения.

\

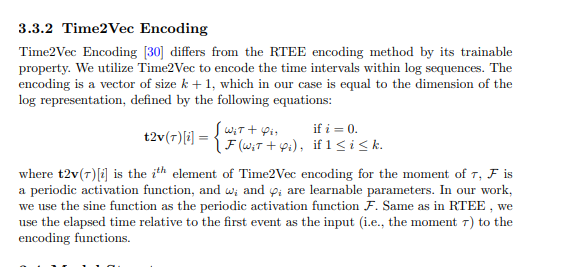

3.4 Структура модели

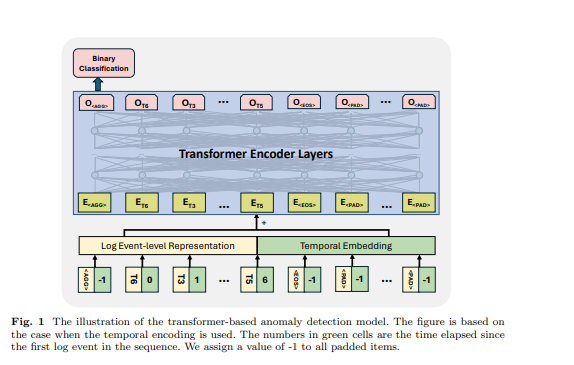

Трансформер - это архитектура нейронной сети, которая опирается на механизм самовнимания для захвата отношений между входными элементами в последовательности. Модели и фреймворки на основе трансформеров использовались в задаче обнаружения аномалий многими предыдущими работами [6, 11, 12, 21]. Вдохновленные предыдущими работами, мы используем модель на основе кодировщика трансформера для обнаружения аномалий. Мы разрабатываем наш подход для приема последовательностей логов различной длины и генерации представлений на уровне последовательности. Для достижения этого мы использовали некоторые специфические токены во входной последовательности логов, чтобы модель могла генерировать представление последовательности и идентифицировать заполненные токены и конец последовательности логов, черпая вдохновение из дизайна модели BERT [31]. Во входной последовательности логов мы использовали следующие токены: размещается в начале каждой последовательности, чтобы позволить модели генерировать агрегированную информацию для всей последовательности, добавляется в конец последовательности, чтобы обозначить ее завершение, используется для маркировки маскированных токенов в рамках парадигмы самоконтролируемого обучения, и используется для заполненных токенов. Встраивания для этих специальных токенов генерируются случайным образом на основе размерности используемого представления лога. Пример показан на рисунке 1, время, прошедшее для , и установлено на -1. Представление на уровне события лога и позиционное или временное встраивание суммируются как входная функция структуры трансформера.

\ 3.5 Контролируемая бинарная классификация В рамках этой цели обучения мы используем выход первого токена модели трансформера, игнорируя выходы других токенов. Этот выход первого токена предназначен для агрегирования информации всей входной последовательности логов, аналогично токену модели BERT, который предоставляет агрегированное представление последовательности токенов. Поэтому мы рассматриваем выход этого токена как представление на уровне последовательности. Мы обучаем модель с целью бинарной классификации (т.е. Binary Cross Entropy Loss) с этим представлением.

\

:::info Авторы:

- Xingfang Wu

- Heng Li

- Foutse Khomh

:::

:::info Эта статья доступна на arxiv под лицензией CC by 4.0 Deed (Attribution 4.0 International).

:::

\

Вам также может быть интересно

СРОЧНО: CoW Protocol (COW) взлетел на 35,9% до $0,256 за 24 часа

Аналитик: Этот обвал XRP выглядит таким фальшивым и постановочным. Вот почему

![[Перевод] Новая элита Китая](https://mexc-rainbown-activityimages.s3.ap-northeast-1.amazonaws.com/banner/F20250806143935754vQ9LpL9Ysj5q6c.png)