Синтез медичних зображень: S-CycleGAN для RUSS та сегментації

Таблиця посилань

Анотація та 1 Вступ

-

Пов'язані роботи

-

Постановка проблеми

-

Методологія

4.1. Дистиляція з урахуванням меж прийняття рішень

4.2. Консолідація знань

-

Експериментальні результати та 5.1. Налаштування експерименту

5.2. Порівняння з методами SOTA

5.3. Дослідження абляції

-

Висновок та майбутня робота та Посилання

\

Додатковий матеріал

- Деталі теоретичного аналізу механізму KCEMA в IIL

- Огляд алгоритму

- Деталі набору даних

- Деталі реалізації

- Візуалізація запилених вхідних зображень

- Більше експериментальних результатів

4. Методологія

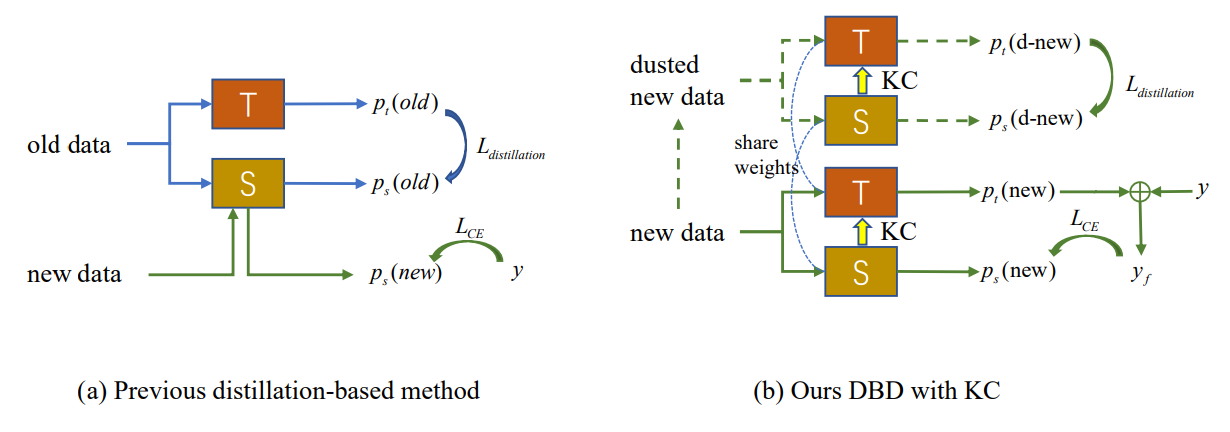

Як показано на рис. 2 (а), виникнення концептуального дрейфу в нових спостереженнях призводить до появи зовнішніх зразків, на яких існуюча модель не працює. Новий IIL повинен розширити межі прийняття рішень до цих зовнішніх зразків, а також уникнути катастрофічного забування (CF) на старій межі. Традиційні методи, засновані на дистиляції знань, покладаються на деякі збережені екземпляри [22] або допоміжні дані [33, 34] для протидії CF. Однак у запропонованому налаштуванні IIL ми не маємо доступу до будь-яких старих даних, окрім нових спостережень. Дистиляція на основі цих нових спостережень конфліктує з вивченням нових знань, якщо до моделі не додаються нові параметри. Щоб досягти балансу між навчанням і запобіганням забуванню, ми пропонуємо метод дистиляції з урахуванням меж прийняття рішень, який не потребує старих даних. Під час навчання нові знання, отримані учнем, періодично консолідуються назад до моделі вчителя, що забезпечує кращу генералізацію і є першою спробою в цій галузі.

\

\

:::info Автори:

(1) Цян Не, Гонконгський університет науки і технології (Гуанчжоу);

(2) Вейфу Фу, Лабораторія Tencent Youtu;

(3) Юхуань Лінь, Лабораторія Tencent Youtu;

(4) Цзялінь Лі, Лабораторія Tencent Youtu;

(5) Іфен Чжоу, Лабораторія Tencent Youtu;

(6) Юн Лю, Лабораторія Tencent Youtu;

(7) Цян Не, Гонконгський університет науки і технології (Гуанчжоу);

(8) Ченцзе Ван, Лабораторія Tencent Youtu.

:::

:::info Ця стаття доступна на arxiv за ліцензією CC BY-NC-ND 4.0 Deed (Attribution-Noncommercial-Noderivs 4.0 International).

:::

\

Вам також може сподобатися

Це не може бути лише Гарольд: тренер UP закликає до більшого внеску в Грі 2

State Street, Galaxy запускають токенізований фонд ліквідності з інвестицією Ondo у $200 млн