Phát hiện bất thường dựa trên Transformer sử dụng nhúng chuỗi nhật ký

Bảng liên kết

Tóm tắt

1 Giới thiệu

2 Nền tảng và Công trình liên quan

2.1 Các công thức khác nhau của Nhiệm vụ Phát hiện Bất thường dựa trên Log

2.2 Có giám sát và Không giám sát

2.3 Thông tin trong Dữ liệu Log

2.4 Nhóm Cửa sổ Cố định

2.5 Các Công trình Liên quan

3 Phương pháp Phát hiện Bất thường dựa trên Transformer có thể Cấu hình

3.1 Công thức Vấn đề

3.2 Phân tích Log và Nhúng Log

3.3 Mã hóa Vị trí & Thời gian

3.4 Cấu trúc Mô hình

3.5 Phân loại Nhị phân có Giám sát

4 Thiết lập Thực nghiệm

4.1 Bộ dữ liệu

4.2 Các Chỉ số Đánh giá

4.3 Tạo Chuỗi Log có Độ dài Khác nhau

4.4 Chi tiết Triển khai và Môi trường Thực nghiệm

5 Kết quả Thực nghiệm

5.1 RQ1: Mô hình phát hiện bất thường đề xuất của chúng tôi hoạt động như thế nào so với các đường cơ sở?

5.2 RQ2: Thông tin tuần tự và thời gian trong chuỗi log ảnh hưởng đến việc phát hiện bất thường như thế nào?

5.3 RQ3: Các loại thông tin khác nhau đóng góp riêng lẻ vào việc phát hiện bất thường như thế nào?

6 Thảo luận

7 Các mối đe dọa đến tính hợp lệ

8 Kết luận và Tài liệu tham khảo

\

3 Phương pháp Phát hiện Bất thường dựa trên Transformer có thể Cấu hình

Trong nghiên cứu này, chúng tôi giới thiệu một phương pháp mới dựa trên transformer để phát hiện bất thường. Mô hình lấy chuỗi log làm đầu vào để phát hiện bất thường. Mô hình sử dụng mô hình BERT đã được đào tạo trước để nhúng các mẫu log, cho phép biểu diễn thông tin ngữ nghĩa trong các thông báo log. Các nhúng này, kết hợp với mã hóa vị trí hoặc thời gian, sau đó được đưa vào mô hình transformer. Thông tin kết hợp được sử dụng trong quá trình tạo biểu diễn cấp chuỗi log tiếp theo, tạo điều kiện cho quá trình phát hiện bất thường. Chúng tôi thiết kế mô hình của mình để linh hoạt: Các tính năng đầu vào có thể cấu hình để chúng tôi có thể sử dụng hoặc tiến hành thí nghiệm với các kết hợp tính năng khác nhau của dữ liệu log. Ngoài ra, mô hình được thiết kế và đào tạo để xử lý các chuỗi log đầu vào có độ dài khác nhau. Trong phần này, chúng tôi giới thiệu công thức vấn đề và thiết kế chi tiết của phương pháp của chúng tôi.

\ 3.1 Công thức Vấn đề

Chúng tôi tuân theo các công trình trước đây [1] để xây dựng nhiệm vụ như một nhiệm vụ phân loại nhị phân, trong đó chúng tôi đào tạo mô hình đề xuất của mình để phân loại chuỗi log thành bất thường và bình thường theo cách có giám sát. Đối với các mẫu được sử dụng trong quá trình đào tạo và đánh giá mô hình, chúng tôi sử dụng phương pháp nhóm linh hoạt để tạo ra các chuỗi log có độ dài khác nhau. Chi tiết được giới thiệu trong Phần 4

\ 3.2 Phân tích Log và Nhúng Log

Trong công việc của chúng tôi, chúng tôi chuyển đổi các sự kiện log thành các vector số bằng cách mã hóa các mẫu log với một mô hình ngôn ngữ đã được đào tạo trước. Để có được các mẫu log, chúng tôi áp dụng bộ phân tích Drain [24], được sử dụng rộng rãi và có hiệu suất phân tích tốt trên hầu hết các bộ dữ liệu công khai [4]. Chúng tôi sử dụng mô hình sentence-bert đã được đào tạo trước [25] (tức là all-MiniLML6-v2 [26]) để nhúng các mẫu log được tạo ra bởi quá trình phân tích log. Mô hình đã được đào tạo trước với mục tiêu học tập đối chiếu và đạt được hiệu suất tiên tiến trên nhiều nhiệm vụ NLP khác nhau. Chúng tôi sử dụng mô hình đã được đào tạo trước này để tạo ra một biểu diễn nắm bắt thông tin ngữ nghĩa của các thông báo log và minh họa sự tương đồng giữa các mẫu log cho mô hình phát hiện bất thường hạ nguồn. Kích thước đầu ra của mô hình là 384.

\ 3.3 Mã hóa Vị trí & Thời gian

Mô hình transformer ban đầu [27] áp dụng mã hóa vị trí để cho phép mô hình sử dụng thứ tự của chuỗi đầu vào. Vì mô hình không chứa sự lặp lại và không có phép tích chập, các mô hình sẽ không nhận biết được chuỗi log mà không có mã hóa vị trí. Mặc dù một số nghiên cứu cho thấy các mô hình transformer không có mã hóa vị trí rõ ràng vẫn cạnh tranh với các mô hình tiêu chuẩn khi xử lý dữ liệu tuần tự [28, 29], điều quan trọng cần lưu ý là bất kỳ hoán vị nào của chuỗi đầu vào sẽ tạo ra cùng một trạng thái nội bộ của mô hình. Vì thông tin tuần tự hoặc thông tin thời gian có thể là chỉ báo quan trọng cho các bất thường trong chuỗi log, các công trình trước đây dựa trên mô hình transformer sử dụng mã hóa vị trí tiêu chuẩn để đưa thứ tự của các sự kiện log hoặc mẫu vào chuỗi [11, 12, 21], nhằm phát hiện các bất thường liên quan đến thứ tự thực thi sai. Tuy nhiên, chúng tôi nhận thấy rằng trong một triển khai sao chép thường được sử dụng của phương pháp dựa trên transformer [5], mã hóa vị trí thực sự đã bị bỏ qua. Theo hiểu biết tốt nhất của chúng tôi, không có công trình hiện có nào mã hóa thông tin thời gian dựa trên dấu thời gian của log cho phương pháp phát hiện bất thường của họ. Hiệu quả của việc sử dụng thông tin tuần tự hoặc thời gian trong nhiệm vụ phát hiện bất thường vẫn chưa rõ ràng.

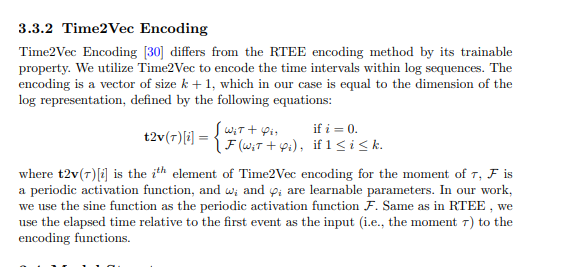

\ Trong phương pháp đề xuất của chúng tôi, chúng tôi cố gắng kết hợp mã hóa tuần tự và thời gian vào mô hình transformer và khám phá tầm quan trọng của thông tin tuần tự và thời gian cho việc phát hiện bất thường. Cụ thể, phương pháp đề xuất của chúng tôi có các biến thể khác nhau sử dụng các kỹ thuật mã hóa tuần tự hoặc thời gian sau đây. Mã hóa sau đó được thêm vào biểu diễn log, đóng vai trò là đầu vào cho cấu trúc transformer.

\

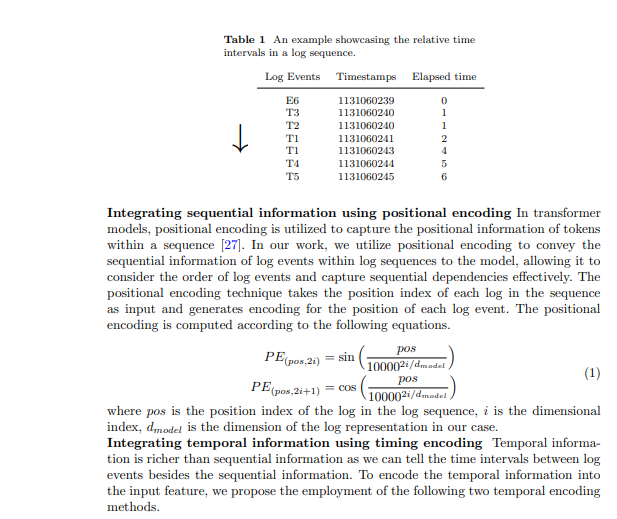

3.3.1 Mã hóa Thời gian Trôi qua Tương đối (RTEE)

Chúng tôi đề xuất phương pháp mã hóa thời gian này, RTEE, đơn giản thay thế chỉ số vị trí trong mã hóa vị trí bằng thời gian của mỗi sự kiện log. Đầu tiên, chúng tôi tính toán thời gian trôi qua theo dấu thời gian của các sự kiện log trong chuỗi log. Thay vì sử dụng chỉ số chuỗi sự kiện log làm vị trí cho các phương trình sin và cosin, chúng tôi sử dụng thời gian trôi qua tương đối đến sự kiện log đầu tiên trong chuỗi log để thay thế chỉ số vị trí. Bảng 1 cho thấy một ví dụ về khoảng thời gian trong một chuỗi log. Trong ví dụ, chúng tôi có một chuỗi log chứa 7 sự kiện với khoảng thời gian 7 giây. Thời gian trôi qua từ sự kiện đầu tiên đến mỗi sự kiện trong chuỗi được sử dụng để tính toán mã hóa thời gian cho các sự kiện tương ứng. Tương tự như mã hóa vị trí, mã hóa được tính toán với các phương trình 1 đã đề cập ở trên, và mã hóa sẽ không cập nhật trong quá trình đào tạo.

\

3.4 Cấu trúc Mô hình

Transformer là một kiến trúc mạng thần kinh dựa vào cơ chế tự chú ý để nắm bắt mối quan hệ giữa các phần tử đầu vào trong một chuỗi. Các mô hình và khung dựa trên transformer đã được sử dụng trong nhiệm vụ phát hiện bất thường bởi nhiều công trình trước đây [6, 11, 12, 21]. Lấy cảm hứng từ các công trình trước đây, chúng tôi sử dụng một mô hình dựa trên bộ mã hóa transformer cho việc phát hiện bất thường. Chúng tôi thiết kế phương pháp của mình để chấp nhận các chuỗi log có độ dài khác nhau và tạo ra các biểu diễn cấp chuỗi. Để đạt được điều này, chúng tôi đã sử dụng một số token cụ thể trong chuỗi log đầu vào để mô hình tạo ra biểu diễn chuỗi và xác định các token được đệm và kết thúc của chuỗi log, lấy cảm hứng từ thiết kế của mô hình BERT [31]. Trong chuỗi log đầu vào, chúng tôi đã sử dụng các token sau: được đặt ở đầu mỗi chuỗi để cho phép mô hình tạo ra thông tin tổng hợp cho toàn bộ chuỗi, được thêm vào cuối chuỗi để biểu thị sự hoàn thành của nó, được sử dụng để đánh dấu các token bị che dưới mô hình đào tạo tự giám sát, và được sử dụng cho các token được đệm. Các nhúng cho các token đặc biệt này được tạo ra ngẫu nhiên dựa trên kích thước của biểu diễn log được sử dụng. Một ví dụ được hiển thị trong

Có thể bạn cũng thích

Khối lượng giao dịch IBIT của BlackRock đạt 10 tỷ USD trong bối cảnh Bitcoin sụp đổ

Doanh nghiệp token hóa kêu gọi EU nới lỏng DLT Pilot Regime để tránh tụt hậu trước Mỹ