企业协作中人工智能代理的用户体验研究方法演变

\ 这种转变比任何人预测的都要快。有一天,人工智能还在自动完成我们的句子。第二天,它就开始加入我们的会议,总结我们的对话,并代表我们起草后续信息。现在它已经在做决策了。

我花了多年时间研究团队如何通过智能平台协作,而我今天所见证的是自电子邮件引入以来工作场所动态最显著的转变。人工智能代理不再只是我们使用的工具。它们是我们并肩工作的参与者。

这种区别对UX研究人员来说非常重要。当软件开始表现得像团队成员时,我们开发的评估软件功能的方法就不再适用了。

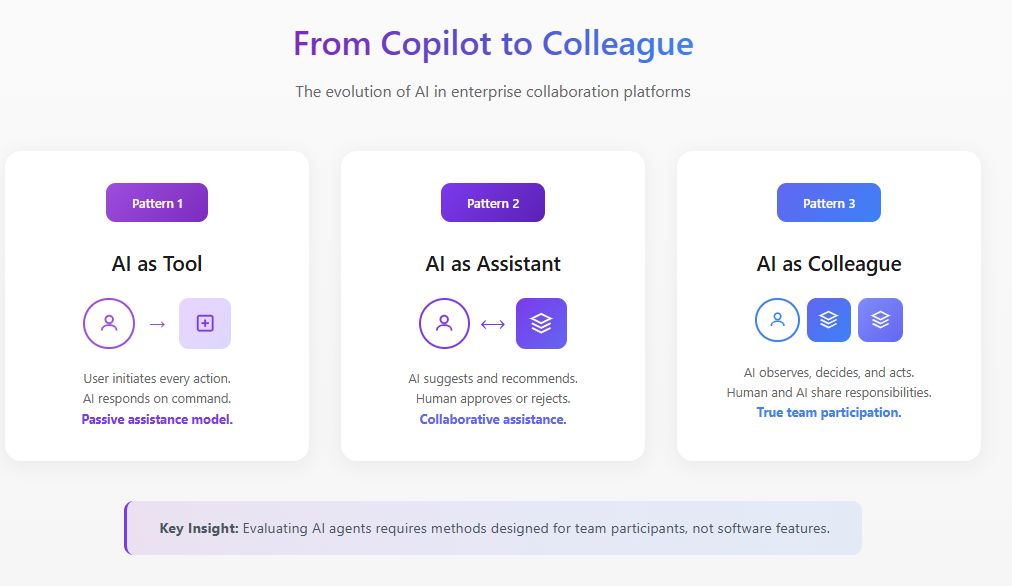

根本性转变:从功能到参与者

传统的UX研究会问这样的问题:这个功能容易被发现吗?交互是否直观?它是否减少了工作流程中的摩擦?

这些问题假设人工智能是被动的,在响应前等待用户输入。但人工智能代理的运作方式不同。它们观察、解释、决策和行动。根据麻省理工学院斯隆管理评论和波士顿咨询集团2025年的研究,35%的组织已经开始使用主动型人工智能,另有44%计划很快采用它。然而,47%表示他们没有关于如何使用人工智能的策略。这种采用与理解之间的差距正是UX研究必须介入的地方。

当人工智能代理加入协作平台时,它改变了团队的社交动态。它影响谁说话,何时说话,以及他们感到舒适说什么。评估这些变化需要远超可用性测试的方法。

\

领导企业协作平台的人工智能评估

在我领导智能协作平台的UX研究工作中,我开发了专门为在企业环境中运行的人工智能代理设计的评估框架。这项工作处于产品策略、人工智能开发和人为因素研究的交叉点。

在这种情况下,人工智能评估与传统模型基准测试有根本不同。当人工智能代理在协作平台内运行时,我们不能简单地孤立地测量准确性或响应质量。我们必须评估代理在真实团队的复杂社交和运营动态中的表现。

我通过三个相互关联的层次来处理企业协作的人工智能评估。第一层检查功能性能:代理是否正确识别行动项目,准确总结讨论,并在适当时刻提供相关信息?第二层评估集成质量:代理如何在现有工作流程中无缝运行,不产生摩擦或要求用户改变行为?第三层,也是最常被忽视的一层,评估系统性影响:代理的存在如何随着时间推移影响团队动态、决策质量和协作效果?

哈佛商业评论2025年5月的研究将人工智能代理描述为代表新兴人才类别的"数字队友"。这种框架要求我们评估人工智能代理不仅仅是完成任务,还要评估它们作为团队参与者的功能。我的评估协议包含行为观察、纵向跟踪和结果分析,这些都是传统人工智能基准完全忽略的。

取得最强结果的组织是那些将UX研究直接嵌入到人工智能评估周期中的组织,它们将以人为中心的指标与技术性能指标一起使用。

\

通过战略性UX研究构建超个性化人工智能代理

企业协作平台的下一个前沿是超个性化人工智能代理,它们能够适应个别用户、团队文化和组织环境。这就是UX研究不仅仅是评估性的,而且是生成性的地方,直接塑造这些代理的设计和部署方式。

我一直在领导研究计划,为协作平台上个性化人工智能代理的战略发展提供信息。这项工作涉及理解不同用户类型与人工智能交互的具体模式,团队沟通风格如何在不同职能和地理位置上变化,以及组织文化如何影响用户对人工智能协助的期望。

麦肯锡2025年11月关于人工智能伙伴关系的研究指出,实现人工智能潜力需要重新设计工作流程,使人员、代理和机器人能够有效地一起工作。从产品策略角度看,这意味着人工智能代理不能一刀切。它们必须根据用户偏好和环境因素调整其沟通风格、干预频率和自主水平。

我的研究已经确定了在企业协作环境中最重要的几个个性化维度。沟通风格匹配确保代理能够反映用户自然表达自己的方式,无论是正式还是随意,详细还是简洁。干预时机校准学习个别用户何时偏好主动协助,何时希望不受打扰地工作。信任阈值调整认识到不同用户对人工智能自主性有不同的舒适度,并相应地进行校准。

战略意义重大。为协作平台构建人工智能代理的产品团队需要持续的UX研究输入,以了解个性化功能在不同用户群体中的表现。没有这种研究基础,个性化努力可能会创造出对某些用户感觉侵入性而对其他用户似乎无用的代理。

评估协作环境中人工智能代理的框架

通过对采用人工智能代理进行协作工作流程的跨职能团队进行广泛的实地研究,我开发了一个评估框架,围绕传统方法忽视的四个维度构建。

- 存在影响检查人工智能代理的存在如何改变团队行为,独立于其功能贡献。我观察到,当团队知道有人工智能记录他们的对话时,团队会变得明显更正式。旁边讨论减少。探索性思考被更安全的贡献所取代。

- 代理边界解决人工智能代理的自主权应该从哪里开始和结束,以及团队如何协商这些边界。世界经济论坛2025年关于人工智能代理的指导强调,治理必须通过持续监控促进透明度。在我的研究中,我发现对人工智能自主性的明确偏好很少与揭示的偏好相匹配。团队经常说他们希望人工智能代理采取更多主动,但当代理真正这样做时却抵制。

- 信任校准关注团队如何发展适当的信任,避免过度依赖和利用不足。一个犯了重大错误的人工智能代理可能会破坏数月的信任建设,而一个表现完美的代理可能会造成危险的自满。

- 协作整合检查人工智能代理如何影响团队动态、信息流和集体智慧。人工智能代理是否帮助团队做出更好的决策,还是创造了掩盖浅层思考的彻底幻觉?

案例研究:重新配置人工智能代理范围

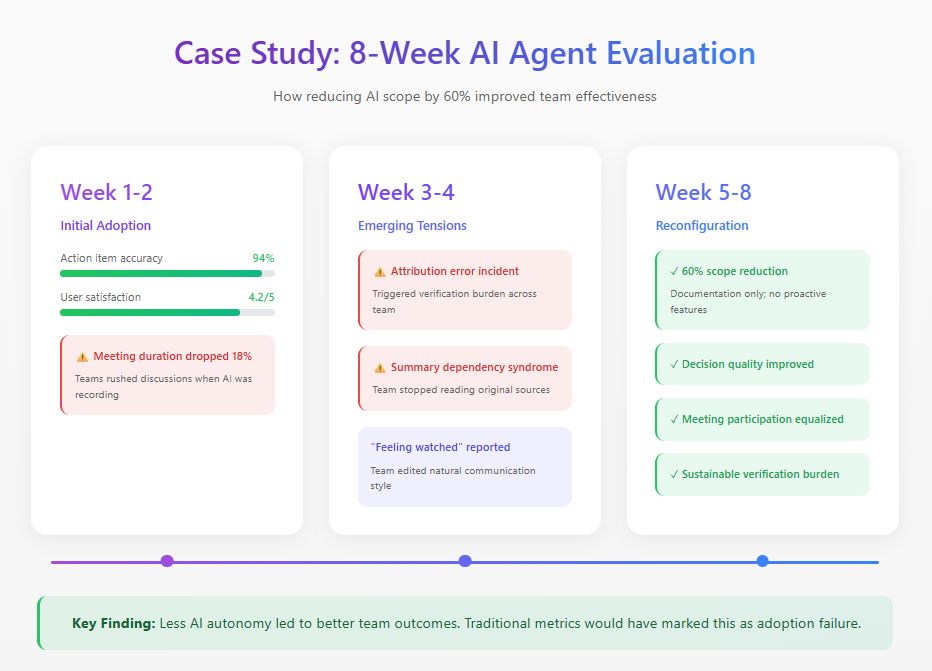

我最近对一个在其协作平台上实施人工智能代理的分布式产品团队进行了为期八周的研究。该代理被设计用来参加会议,生成摘要,跟踪决策,并主动提供相关信息。

初始指标看起来很出色:94%的行动项目准确率,4.2/5的满意度评分。但行为观察揭示了仪表板上看不到的问题。会议时间减少了18%,因为团队成员匆忙讨论,意识到每个字都被记录下来。到第三周,一个归因错误触发了验证负担,消耗的时间比它替代的文档更多。团队成员还发展出我称之为"摘要依赖综合症"的情况,完全依赖人工智能摘要而错过关键背景。

基于这些发现,团队重新配置了人工智能代理,将其功能范围减少了60%。他们移除了主动功能,同时保留了准确度高的文档任务。传统采用指标会将此标记为失败。但团队效能指标讲述了不同的故事:决策质量提高,会议参与变得更加公平,验证负担降至可持续水平。

最重要的发现来自访谈。多位团队成员描述在完全自主阶段感到"被监视"。这种对真实沟通的冷却效应从未出现在任何仪表板指标中。

\

\

实用评估方法

基于这项研究和类似研究,我推荐以下方法来评估协作环境中的人工智能代理。

- 纵向观察要求在人工智能代理引入前建立基线,最少六周的观察期。单次可用性测试几乎无法揭示关于协作人工智能动态的有用信息。

- 沟通模式分析涉及对谁说话、多频繁以及在什么情况下说话进行定量跟踪,跨越部署前、早期部署和成熟部署阶段。

- 信任校准评估定期测量团队成员对人工智能能力的信心与实际人工智能表现的比较。

- 决策质量审计提供对涉及人工智能代理的决策的回顾性分析,跟踪结果并确定人工智能贡献在哪里帮助或阻碍了决策。

前进的道路

人工智能代理将在企业协作中无处不在。研究问题不是组织是否会采用它们,而是如何有效地整合它们。

UX研究人员在塑造这种整合方面扮演着关键角色。我们拥有理解人类行为的方法和评估体验质量的框架。做对这一点的组织将建立人类和人工智能代理真正互补的协作系统。那些将人工智能代理仅仅视为另一个功能的组织将发现他们的团队比技术到来之前工作效率更低。

\

您可能也会喜欢

「麻吉大哥」向 HyperLiquid 存入 21 万美元 USDC 以增加其 ETH 25 倍做多仓位

SEC寻求在孙宇晨案中达成1000万美元和解,针对TRON创办人的指控被撤销