Deteksi Anomali Berbasis Transformer Menggunakan Embeddings Urutan Log

Tabel tautan

Abstrak

1 Pendahuluan

2 Latar Belakang dan Karya Terkait

2.1 Formulasi Berbeda dari Tugas Deteksi Anomali Berbasis Log

2.2 Supervised vs. Unsupervised

2.3 Informasi dalam Data Log

2.4 Pengelompokan Jendela Tetap

2.5 Karya Terkait

3 Pendekatan Deteksi Anomali Berbasis Transformer yang Dapat Dikonfigurasi

3.1 Formulasi Masalah

3.2 Parsing Log dan Embedding Log

3.3 Pengkodean Posisional & Temporal

3.4 Struktur Model

3.5 Klasifikasi Biner Terawasi

4 Pengaturan Eksperimen

4.1 Dataset

4.2 Metrik Evaluasi

4.3 Menghasilkan Urutan Log dengan Panjang Bervariasi

4.4 Detail Implementasi dan Lingkungan Eksperimen

5 Hasil Eksperimen

5.1 RQ1: Bagaimana kinerja model deteksi anomali yang kami usulkan dibandingkan dengan baseline?

5.2 RQ2: Seberapa besar informasi sekuensial dan temporal dalam urutan log mempengaruhi deteksi anomali?

5.3 RQ3: Seberapa besar kontribusi masing-masing jenis informasi terhadap deteksi anomali?

6 Diskusi

7 Ancaman terhadap validitas

8 Kesimpulan dan Referensi

\

3 Pendekatan Deteksi Anomali Berbasis Transformer yang Dapat Dikonfigurasi

Dalam penelitian ini, kami memperkenalkan metode berbasis transformer baru untuk deteksi anomali. Model ini mengambil urutan log sebagai input untuk mendeteksi anomali. Model ini menggunakan model BERT yang telah dilatih sebelumnya untuk menyematkan template log, memungkinkan representasi informasi semantik dalam pesan log. Penyematan ini, dikombinasikan dengan pengkodean posisional atau temporal, kemudian dimasukkan ke dalam model transformer. Informasi gabungan ini digunakan dalam pembuatan representasi tingkat urutan log berikutnya, memfasilitasi proses deteksi anomali. Kami merancang model kami agar fleksibel: Fitur input dapat dikonfigurasi sehingga kami dapat menggunakan atau melakukan eksperimen dengan kombinasi fitur data log yang berbeda. Selain itu, model ini dirancang dan dilatih untuk menangani urutan log input dengan panjang yang bervariasi. Dalam bagian ini, kami memperkenalkan formulasi masalah kami dan desain detail metode kami.

\ 3.1 Formulasi Masalah

Kami mengikuti karya sebelumnya [1] untuk merumuskan tugas sebagai tugas klasifikasi biner, di mana kami melatih model yang kami usulkan untuk mengklasifikasikan urutan log menjadi anomali dan normal secara terawasi. Untuk sampel yang digunakan dalam pelatihan dan evaluasi model, kami menggunakan pendekatan pengelompokan yang fleksibel untuk menghasilkan urutan log dengan panjang yang bervariasi. Detail diperkenalkan di Bagian 4

\ 3.2 Parsing Log dan Embedding Log

Dalam pekerjaan kami, kami mengubah peristiwa log menjadi vektor numerik dengan mengkodekan template log dengan model bahasa yang telah dilatih sebelumnya. Untuk mendapatkan template log, kami mengadopsi parser Drain [24], yang banyak digunakan dan memiliki kinerja parsing yang baik pada sebagian besar dataset publik [4]. Kami menggunakan model sentence-bert yang telah dilatih sebelumnya [25] (yaitu, all-MiniLML6-v2 [26]) untuk menyematkan template log yang dihasilkan oleh proses parsing log. Model yang telah dilatih sebelumnya ini dilatih dengan tujuan pembelajaran kontrastif dan mencapai kinerja state-of-the-art pada berbagai tugas NLP. Kami menggunakan model yang telah dilatih sebelumnya ini untuk membuat representasi yang menangkap informasi semantik pesan log dan menggambarkan kesamaan antara template log untuk model deteksi anomali downstream. Dimensi output model adalah 384.

\ 3.3 Pengkodean Posisional & Temporal

Model transformer asli [27] mengadopsi pengkodean posisional untuk memungkinkan model menggunakan urutan input. Karena model tidak mengandung rekurensi dan tidak ada konvolusi, model akan agnostik terhadap urutan log tanpa pengkodean posisional. Meskipun beberapa penelitian menunjukkan bahwa model transformer tanpa pengkodean posisional eksplisit tetap kompetitif dengan model standar ketika menangani data sekuensial [28, 29], penting untuk dicatat bahwa setiap permutasi urutan input akan menghasilkan keadaan internal model yang sama. Karena informasi sekuensial atau informasi temporal mungkin merupakan indikator penting untuk anomali dalam urutan log, karya sebelumnya yang didasarkan pada model transformer menggunakan pengkodean posisional standar untuk menyuntikkan urutan peristiwa log atau template dalam urutan [11, 12, 21], bertujuan untuk mendeteksi anomali yang terkait dengan urutan eksekusi yang salah. Namun, kami memperhatikan bahwa dalam implementasi replikasi yang umum digunakan dari metode berbasis transformer [5], pengkodean posisional sebenarnya dihilangkan. Sejauh pengetahuan kami, tidak ada karya yang ada yang mengkodekan informasi temporal berdasarkan stempel waktu log untuk metode deteksi anomali mereka. Efektivitas penggunaan informasi sekuensial atau temporal dalam tugas deteksi anomali tidak jelas.

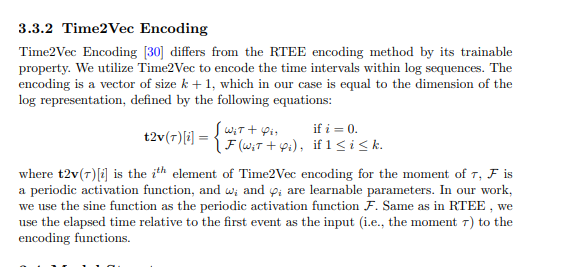

\ Dalam metode yang kami usulkan, kami mencoba menggabungkan pengkodean sekuensial dan temporal ke dalam model transformer dan mengeksplorasi pentingnya informasi sekuensial dan temporal untuk deteksi anomali. Secara khusus, metode yang kami usulkan memiliki varian berbeda yang menggunakan teknik pengkodean sekuensial atau temporal berikut. Pengkodean kemudian ditambahkan ke representasi log, yang berfungsi sebagai input ke struktur transformer.

\

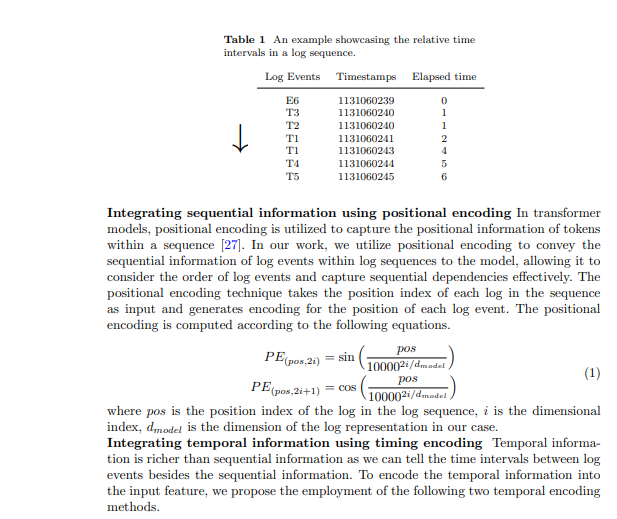

3.3.1 Pengkodean Waktu Berlalu Relatif (RTEE)

Kami mengusulkan metode pengkodean temporal ini, RTEE, yang secara sederhana menggantikan indeks posisi dalam pengkodean posisional dengan waktu setiap peristiwa log. Kami pertama-tama menghitung waktu berlalu sesuai dengan stempel waktu peristiwa log dalam urutan log. Alih-alih menggunakan indeks urutan peristiwa log sebagai posisi untuk persamaan sinusoidal dan kosinusoidal, kami menggunakan waktu berlalu relatif terhadap peristiwa log pertama dalam urutan log untuk menggantikan indeks posisi. Tabel 1 menunjukkan contoh interval waktu dalam urutan log. Dalam contoh tersebut, kami memiliki urutan log yang berisi 7 peristiwa dengan rentang waktu 7 detik. Waktu yang berlalu dari peristiwa pertama ke setiap peristiwa dalam urutan digunakan untuk menghitung pengkodean waktu untuk peristiwa yang sesuai. Mirip dengan pengkodean posisional, pengkodean dihitung dengan persamaan 1 yang disebutkan di atas, dan pengkodean tidak akan diperbarui selama proses pelatihan.

\

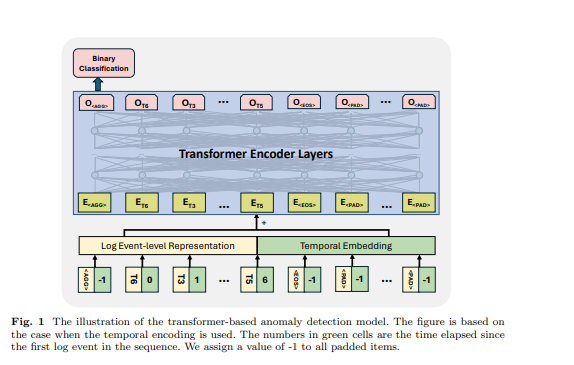

3.4 Struktur Model

Transformer adalah arsitektur jaringan saraf yang mengandalkan mekanisme self-attention untuk menangkap hubungan antara elemen input dalam urutan. Model dan kerangka kerja berbasis transformer telah digunakan dalam tugas deteksi anomali oleh banyak karya sebelumnya [6, 11, 12, 21]. Terinspirasi oleh karya sebelumnya, kami menggunakan model berbasis encoder transformer untuk deteksi anomali. Kami merancang pendekatan kami untuk menerima urutan log dengan panjang yang bervariasi dan menghasilkan representasi tingkat urutan. Untuk mencapai ini, kami telah menggunakan beberapa token khusus dalam urutan log input agar model dapat menghasilkan representasi urutan dan mengidentifikasi token yang diisi dan akhir urutan log, terinspirasi dari desain model BERT [31]. Dalam urutan log input, kami menggunakan token berikut: ditempatkan di awal setiap urutan untuk memungkinkan model menghasilkan informasi agregat untuk seluruh urutan, ditambahkan di akhir urutan untuk menandakan penyelesaiannya, digunakan untuk menandai token yang dimasking di bawah paradigma pelatihan yang diawasi sendiri, dan digunakan untuk token yang diisi. Embedding untuk token khusus ini dihasilkan secara acak berdasarkan dimensi representasi log yang digunakan. Contoh ditunjukkan pada Gambar 1, waktu yang berlalu untuk , dan diatur ke -1. Representasi tingkat peristiwa log dan embedding posisional atau temporal dijumlahkan sebagai fitur input struktur transformer.

\ 3.5 Klasifikasi Biner Terawasi Di bawah tujuan pelatihan ini, kami menggunakan output token pertama dari model transformer sambil mengabaikan output token lainnya. Output token pertama ini dirancang untuk mengumpulkan informasi dari seluruh urutan log input, mirip dengan token dari model BERT, yang memberikan representasi agregat dari urutan token. Oleh karena itu, kami menganggap output token ini sebagai representasi tingkat urutan. Kami melatih model dengan tujuan klasifikasi biner (yaitu, Binary Cross Entropy Loss) dengan representasi ini.

\

:::info Penulis:

- Xingfang Wu

- Heng Li

- Foutse Khomh

:::

:::info Makalah ini tersedia di arxiv di bawah lisensi CC by 4.0 Deed (Attribution 4.0 International).

:::

\

Anda Mungkin Juga Menyukai

Penelitian LightSite AI Menunjukkan: Merek Global Dikalahkan Dalam Pencarian AI Oleh Pesaing Lebih Kecil dan Terfokus

Binance Memenangkan Persetujuan Penuh ADGM untuk Operasi Pertukaran, Kliring, dan Pialang

Salin tautanX (Twitter)LinkedInFacebookEmail